این روزها به خاطر حجم عظیم عکسهای موجود در اینترنت از آدمهای معروف و نامآشنا، دیپفیک کار چندان سختی نیست. در روزهای اولی که دیپفیک سر و کلهاش پیدا شده بود، تشخیص دادن آن کار راحتی بود –حتی بهترین آنها نیز دارای سوتیهای تصویری بودند، مثل تار شدن، کج و کوله بودن، تفاوتهای فاحش غیرطبیعی که داد میزدند ما دیپفیک هستیم.

حالا اما وضعیت موش و گربه است، هر چه ما راه و رسم تشخیص دیپفیک را پیدا میکنیم، در نسل بعدی این راهها را میبندند و ایرادها را برطرف میکنند. برای مبارزه با این ویدئوها و فهمیدن اینکه کدام ویدئو دارد ما را گول میزند، آیا راهحل مطمئنی وجود دارد؟

سرنخ تصویری

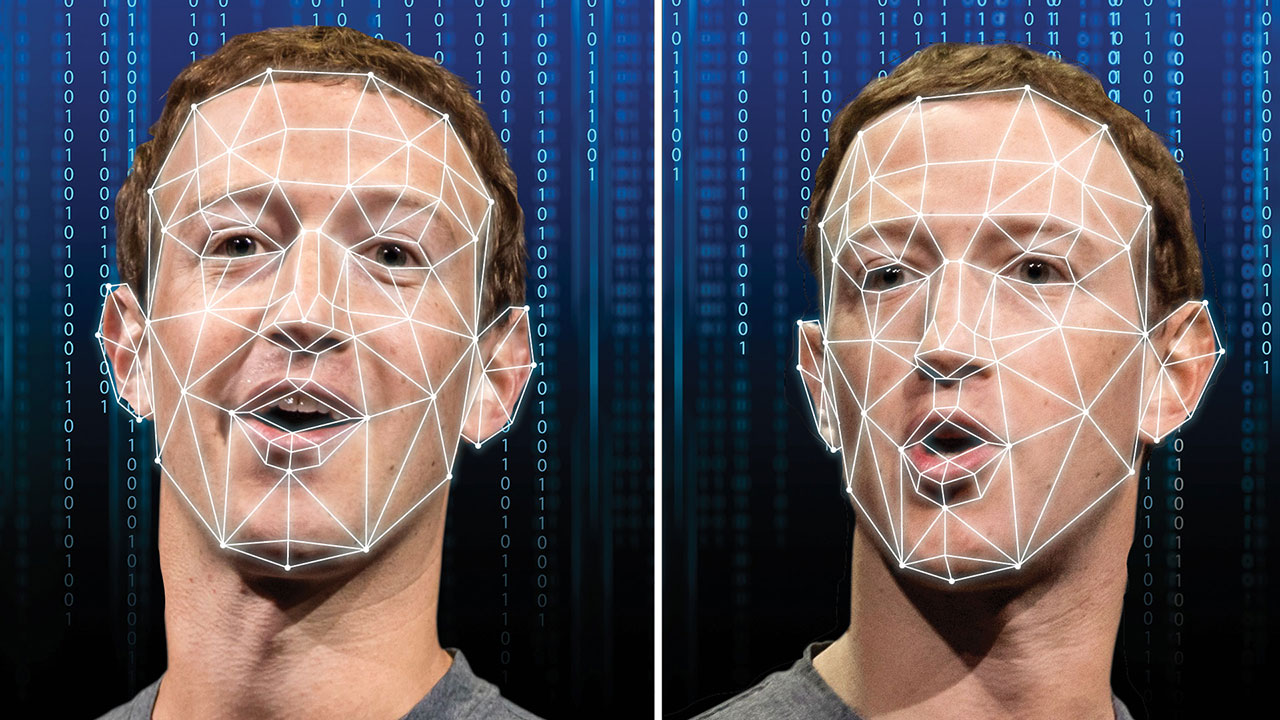

آثار دستساز انسانی فقط محدود به چیزهایی که ایندینا جونز مییابد و به موزه میسپارد نیست – دستکاریهای ریز موجود در عکسها و ویدئوهای قلابی نیز به نوعی آثار انسانیاند. در دیپفیکهای اولیه میشد این دستکاریها را با چشم غیرمسلح دید، اما حالا هم در دیپفیکهای بد قابل تشخیصاند، مثل تار شدن اطراف لبهها، چهرههای بیش از حد صاف شده، ابروهای دوتایی، خرابیها یا کلا ظاهر غیرطبیعیای که بعضیهایشان دارند.

بیشتر مواقع اما، تکنیکهای دیپفیک چنان پیشرفته شده است که این دستکاریها فقط با روشهایی مثل مرتبسازی الگوریتمی بر مبنای دادههای ویدئو و یا بررسی تکتک پیکسلها قابل تشخیص است. بعضی از این روشها واقعا خلاقانه هستند، مانند روشی که در آن جهت بینی را با جهت چهره چک میکنند تا ببینید یکی است یا خیر. این تفاوتها آنقدر زیرکانه و هوشمندانه است که تشخیص آنها برای انسان بسیار سخت است، اما کامپیوتر در این کار کاملا خبره است.

سرنخ بیومتریک

برای مدت کوتاهی، کلید تشخیص دیپفیک پلکزدن غیرطبیعی سوژه بود، آن هم به این دلیل بود که در اینترنت عکسهایی که این سوژهها چشمشان بسته است، بسیار کم بود، یا اصلا پیدا نمیشد. اما به هر حال زمان زیادی طول نکشید که نسل بعدی تکنولوژی دیپفیک این ایراد تکنیکی را برطرف کردند.

یکی دیگر از شاخصهای بیومتریکی که البته هنوز کاملا برطرف نشده، تغییرات ناگهانی اجزای صورت است، چون الگوریتم دیپفیک به علت عدم درک مفهومی از زبان این تغییرات ناگهانی، نمیتواند به راحتی آنها را شبیهسازی کند. شاید دیپفیک بتواند عادتهای کوچک، مثل سریع پلک زدن هنگام غافلگیر شدن یا بالا رفتن ابرو هنگام سوال پرسیدن، را شبیه سازی کند، اما لزوما نمیتواند در زمان مناسب این کار را انجام دهد، چون (هنوز) نمیتواند به طور خودکار زمان این حرکات را تشخیص دهد.

هوش مصنوعی قابلیت این را دارد که از ویدئوها ضربان قلب را تشخیص دهد و این قابلیت مهمترین تکنیک تشخیص دیپفیک است، اما حرکات متناوب و تغییرات رنگ که ضربان قلب را نشان میدهد نیز در تشخیص دیپفیک کمککننده است. مشخصترین نقض و ایراد دیپفیک زمانی است که سوژه هیچ ضربان قلبی ندارد، اما کم پیش میآید و اغلب آنها ضربان دارند. به هر حال، هنوز هم میشود با استفاده از بینظمی اجزای سوژه (مانند اینکه اجزای مختلف صورت ضربان متفاوتی را نشان میدهند) دیپفیک را تشخیص دهیم.

پروژههای هوش مصنوعی

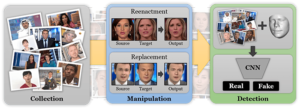

برندهای بزرگ بسیار مشتاق هستند که مسئلهی دیپفیک را حل کنند. فیسبوک، گوگل، امآیتی، آکسفورد، برکلی و بسیاری از استارتآپها و محققین در حال کلنجار رفتن با دیپفیک هستند و از طریق آموزش روشهای گوناگون از جمله همین روشهایی که در بالا اشاره کردیم، به دنبال آن هستند که هوش مصنوعی را توانمند کنند تا ویدئوهای قلابی را تشخیص دهد.

روشی که فیسبوک و گوگل مشغول کار روی آن هستند، تقریبا شبیه مهندسی معکوس است. به این صورت که مجموعهای از ویدئوهای باکیفیت از بازیگران معروف در حالتهای مختلف تهیه میکنند و با استفاده از آنها دیپفیک میسازند. هوش مصنوعی به کار رفته در این پروژه یاد میگیرد که راه و رسم دیپفیک چطور است و از همین روشّها برای تشخیص دیپفیک کمک میگیرد.

البته، این روش مستلزم آن است که محققان همواره با استفاده از آخرین روشّهای دیپفیک در حال تولید ویدئوهای قلابی باشند، اما در این صورت همیشه فاصلهای بین جدیدترین روشهای دیپفیک کشفشده و الگوریتم تشخیص دیپفیک وجود خواهد داشت. از طرفی، این امید هم وجود دارد که آزمایشهای تشخیص دیپفیک روی موشّها جواب دهد و در این راه کمک بسیار بزرگی به انسانها باشند.

اصالتسنجی

تکنولوژیهای تشخیص دیپفیک راهحل کاملی برای مسئلهی دیپفیک نیستند، چرا که احتمالا هیچوقت موفقیت آنها صد در صد نیست. زمان و هزینهی زیادی صرف دیپفیکها میشود تا بتوانند آزمونهای تشخیص و روشّهای هوش مصنوعی را دور بزنند. و از طرفی فراموش نکنید که راه و رسم اینترنت چطور است: اگر دست دیپفیکها هم رو شود، احتمال اینکه دوباره سر و کلهشان پیدا شود و افرادی هم آنها را باور کنند، کم نیست!

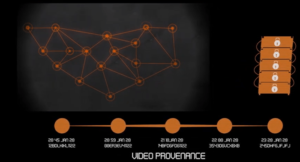

به همین خاطر بسیار مهم است که مکانیزمی برای تایید اصالت وجود داشته باشد؛ سندی که تایید کند چه ویدئویی اصل است و چه ویدئویی دستکاری شده. شرکتهای مانند Factom، Ambervideo و Axiom از طریق کدبندی دادههای ویدئوها به شکل بلاکچینهای تغییرناپذیر، دقیقا همین کار را انجام میدهند.

اساس این پروژهها به این صورت است: از دادهی تشکیلدهندهی یک فایل ویدئو یا تولیدشدهی یک دوربین خاص، یک امضای خاص و یکتا تولید میکنند، که اگر ویدئو را دستکاری کنند، این امضا تغییر میکند. در نهایت اینکه، ویدئوهایی که در شبکهّهای اجتماعی آپلود میشود قابلیت این را دارند که یک کد اصالتسنجی تولید کنند؛ کدی که صاحب ویدئو در بلاکچین ثبت کرده است و با آن کد ثابت میکنند صاحب اصلی ویدئو هستند.

این راهحلها به هر حال مشکلات خودشان را دارند، مانند کدبندی ویدئو که دادههای فایل ویدئو را تغییر میدهد و موجب میشود امضای فایل عوض شود بدون اینکه واقعا محتوای ویدئو تغییر کند و یا ممکن است ویرایش ویدئو نیز موجب تغییر امضا شود. اما در سطوح بالاتر، مانند مبادلات بازرگانی که برای رسید تحویل یا تایید سرمایهگذار از تصاویر استفاده میکنند، داشتن یک لایهی اصالتسنجی میتواند از کلاهبرداری توسط دیپفیک جلوگیری کند.

آیا دیپفیک از فتوشاپ خطرناکتر است؟

حالا دیگر همه ما به این آگاهی رسیدهایم که یک عکس هرچقدر هم که طبیعی به نظر برسد، ممکن است واقعی نباشد. در نهایت اینکه باید از این به بعد نگاهمان به ویدئوها با شک و تردید باشد، همانطور که به عکسها نیز، با آگاهی به وجود فتوشاپ و راحت بودن تغییر یک عکس، با شک و تردید مینگریم. با این آگاهی کلی تصورش راحت است که در آیندهای نه چندان دور بسیاری از اجزای تشکیلدهندهی زندگیمان تبدیل به دیپفیکهای با کیفیت شوند.